سئو-طراحی سایت

سئو-طراحی سایتسئو-طراحی سایت

سئو-طراحی سایتچه لینک هایی از نظر گوگل غیر واقعی هستند؟

با توجه به تعدد پرسشهای کاربران محترم، امروز مقاله ای را تحت عنوان ذکر شده خدمتتان ارائه می کنیم.

همانطور که پیشتر اشاره کردیم، گوگل پس از ارائۀ الگوریتم پنگوئن و

سپس پنگوئن 2، ضد اسپم خود را تا جای ممکن فعال و بخشی را تحت عنوان واکنش

دستی که توسط کارمندان

گوگل مدیریت می شود ارتقا داد و موضوع بک لینک ها و بک لینک فروشی نیز حداقل در این حالتی که جا افتاده بود حذف و غیر کارآمد شد.

برای

بازدید گرفتن و رسیدن به جایگاه مطلوب خود در گوگل، راه هایی را نظیر

نوشتن به عنوان میهمان و فعالیت حرفه ای (و نه اسپم گونه) هم در مقالات

پیشین بدان اشاره شد و هم بیشتر در این ارتباط خواهیم نوشت.

امروز اما، در خدمتتان هستیم و در ارتباط با بک لینک های غیر واقعی و در واقع تقلبی گفتگو می کنیم.

مدت

تقریبا قابل توجهی است که فروختن بک لینک به یک بیزینس بدون دردسر و البته

با کلاه گذاشتن بر سر ربات های گوگل تبدیل شده است. بدین معنی که فرض

بفرمایید اگر یک زمانی وبمستران و بلاگرهای ایرانی تنها از روی عشق و علاقه

و ایجاد رابطه ای چند سویه بدون توجه به موضوعاتی چون سئو، پیج رنک، رتبه و

جایگاه گرفتن در نتایج گوگل، یکدیگر را لینک می کردند، امروز اما شرایط به

گونۀ دیگریست. سایتهایی به وجود آمدند که پشت سرشان ممکن بود صد یا هزار

عدد وبلاگ و سایت با یک سری محتوای تکراری، بی خاصیت و غیر مفید وجود داشته

باشند.

مدیران این تارنماها، پس از مدتی که از گوگل رنک می گرفتند،

لینک تمامی سایتهایشان را به یک صفحۀ استاتیک و ساده منتقل می کردند و

برای درج تبلیغ شما (یا همان بک لینک معروف غیر واقعی) بر اساس رنکی که از

خود گوگل گرفته بودند، اقدام به فریب گوگل نموده و بر اساس همان رنک دریافت

شده به سایر مدیران سایت ها و وبلاگ ها تعرفه می دادند؛ و این مدیران ساده

اندیش و بدون اطلاع بودند که کمترین تجربه ای در زمینۀ سئو و بک لینک

نداشتند و گرفتار مسائل و سختی های سئو می شدند. چراکه اگر کوچکترین اطلاعی

از موضوع سئو می داشتند، این هزینه، امید و وقتشان را بر روی سئوی حرفه ای

سایتشان می گذاشتند تا برایشان نتیجه بخش باشد.

امروزه اما همانطور که گفته شد گوگل این نوع سایت ها و وبلاگ ها را جریمه خواهد کرد.

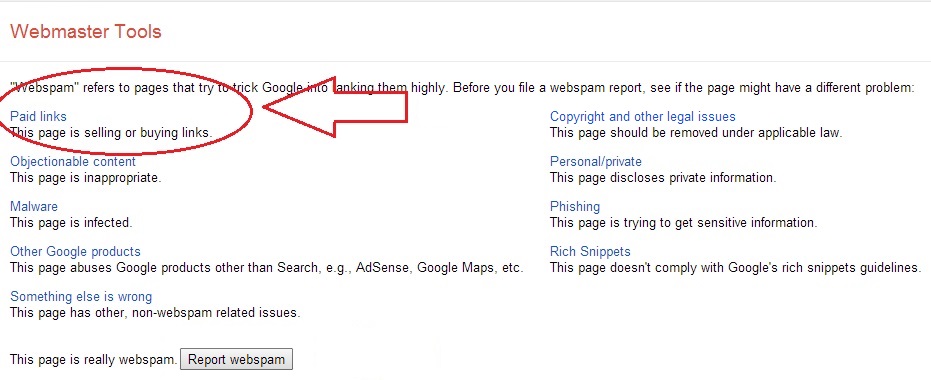

طبق

مقاله ای که توسط بخش وبمسترتولز نوشته شده، نگاهی داریم به لینک های غیر

واقعی و مشکلاتی که برای یک کاربر غیر وارد ممکن است به وجود آید. هر نوع

پیوندی که تنها به صرف و هدف افزایش پیج رنک سایت و یا بهبود رتبه بندی شما

در نتایج گوگل ایجاد میشود بعنوان لینک غیر طبیعی شناخته خواهد شد و

برخلاف راهنمایی ها و اصول وبمستر گوگل است. که شامل لینک های ورودی به

سایت و خروجی از آن میشود.

بک لینک های غیر طبیعی مخرب هستند

یک

مثال و راه حل: وبسایت یا وبلاگی تنها به قصد بک لینک شدن و فروختن بک

لینک ایجاد می شود و مطالبی غیر مفید بر روی خروجی آن درج می شود. در

صورتیکه این تارنما و تارنماهای مشابه، پس از مدتی از آغاز فعالیت شروع به

لینک دادن به یک سایت خاص کنند، نه تنها بک لینک ها (که شکلی شبیه به یک

سایت معمولی دارند) جریمه می شوند (طبق آخرین آپدیت الگوریتم گوگل) که سایت

لینک داده شده نیز در معرض خطر ربات های جستجوگر گوگل قرار خواهند گرفت.

راه حل

در یک واژه Disavow کردن این لینک ها و این سایت ها را می توان پیشنهاد نمود.

اما Disavow links چیست؟ و چگونه عمل می کند؟

وبمستر

می تواند برای اطلاع دادن به ربات های جستجوگر در این مورد که آن لینک

مورد نظر، مخرب است و سایت وی تمایلی به لینک شدن سایت خود ندارد، با تکمیل

نمودن فرمی این مساله را به اطلاع ربات های گوگل می رساند و خود را از

گزند لینک های مخرب حفظ می کند.

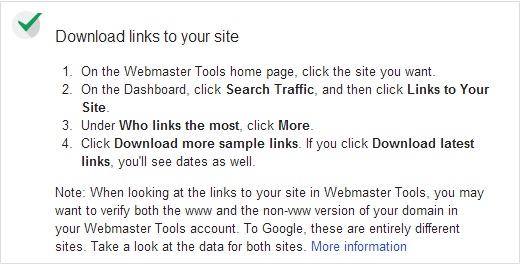

نحوۀ عملکرد Disavow links در وبمسترتولز

به صفحۀ اصلی وبمسترتولز بروید و بر روی سایت مورد نظرتان کلیک کنید.

در قسمت داشبورد، روی Search Traffic کلیک کنید و سپس Links to Your Site را برگزینید.

زیر عبارت Who links the most، بر روی More کلیک کنید.

روی Download more sample links کلیک کنید. اگر روی Download latest links

کلیک کنید نیز آخرین تاریخ ها را نیز مشاهده خواهید کرد.

زمانیکه

در حال دیدن لینک های سایت خود در وبمسترتولز هستید، ممکن است بخواهید هر

دو نسخۀ دومین با www و بدون www را تایید کنید. برای گوگل این دو کاملا

متفاوت هستند. نگاهی به اطلاعات هر دو بیندازید. (اطلاعات بیشتر)

به ترتیب زیر می توانید لینک های مورد نظر را Disavow کنید.

به صفحۀ diwavow links tool page بروید.

سایت خود را انتخاب کنید.

بر روی Disavow links کلیک کنید.

بر روی Choose file کلیک کنید.

نکته: بارگذاری یک فایل جدید باعث از بین رفتن بارگذاری های پیشین و جایگذاری فایل جدید با فایل قدیمی خواهد شد.

چگونه از کپی شدن مطالبمان با کمک گوگل جلوگیری کنیم؟

موارد حقوقی همیشه قابل توجه و با اهمیت بوده اند اما بسیار کمتر به آنها توجه میکنیم و از پیچ و خمشان آگاهیم. شاید هم این، خطای بسیاری از ما و همکاران ماست که در این امور تفحص و تحقیق میکنند اما همین محتوا را با کاربران فارسی زبان به اشتراک نمیگذارند. ما در اینجا این مسائل را باز میکنیم و در جهت تضییع نشدن حقوقتان در موضوع کپی رایت، اطلاعات ناب و درجۀ اولی در اختیارتان قرار می دهیم. با ما همراه باشید...

به گوگل خوش آمدید...

از شما بابت استفاده از خدمات و محصولاتمان سپاسگزاریم. این خدمات توسط شرکت گوگل ارائه شده اند. گوگل واقع در ایالات متحدۀ امریکا، کالیفرنیا 94043، مانتین ویو است.

با استفاده از خدمات ما، شما قوانین حقوقی ما را میپذیرید. لطفا دقیق مطالعه نمایید.

ما در اینجا، با توجه به موضوع مقاله، به توضیحات مکفی در ارتباط با مسالۀ حقوقی حمایت از تولیدکنندگان محتوا میپردازیم.

گوگل در این زمینه و در بخش "حقوق خصوصی و حفاظت از کپی رایت" میگوید:

سیاست حفظ حقوق خصوصی گوگل توضیح میدهد که چگونه از اطلاعات و حریم شخصی شما حفاظت میکند. با استفاده از سرویسهای ما، میپذیرید که گوگل میتواند از بخشی از اطلاعات شما بر اساس سیاستهای حقوقی اش استفاده کند.

ما بر اساس ابزار U.S. Digital Millennium Copyright Act، پیگیر ادعاهای افرادیکه حقوقشان تضییع شده هستیم و در صورت صحت ادعا، حساب متخلفین را مسدود خواهیم کرد.

ما مالکیت معنوی و حقوقی آنلاین افراد را به رسمیت می شناسیم. اگر شما فکر میکنید که کسی در حال نقض حقوق شماست و قصد اطلاع رسانی به ما را دارید؛ می توانید اطلاعات مورد نظر خود در این باره را به ما گزارش دهید.

ثبت گزارش در هر یک از سرویس های گوگل، ممکن است جهت بررسی تا یک هفته نیز زمان ببرد و حتا پس از رسیدگی به شکایت شما، از طریق ایمیل، اس ام اس یا فکس مطلع نخواهید شد اما گوگل پس از تکمیل این فرم برای شما یک ایمیل تاییدیه ارسال می کند. شما خودتان باید روزانه بخش مورد شکایت را بررسی نمایید و رسیدن به حقوقتان را پیگیری کنید.

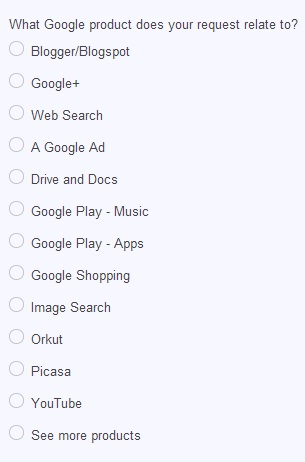

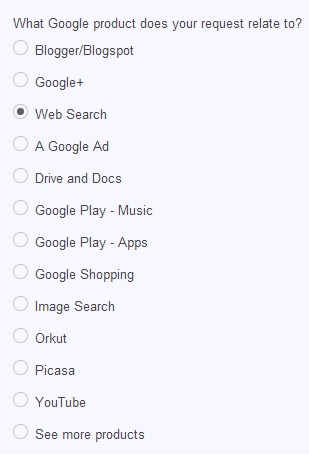

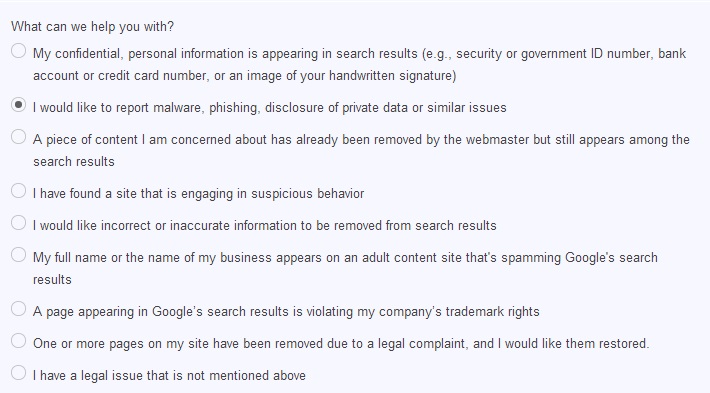

همچنین برای پیشرفت وب فارسی و همچنین رشد بیشتر محتوا و عدم کپی برداری سایت های متقلب از سایرین، میتوانید با تکمیل این فرم در بخش جستجوی وب، گزارش مورد نظر را به گوگل بفرستید. این موضوع همچنین باعث خواهد شد که محتواهای مورد نظرتان را در چندین و چند سایت ندیده و هر روز شاهد محتوایی نو و جدید باشیم.

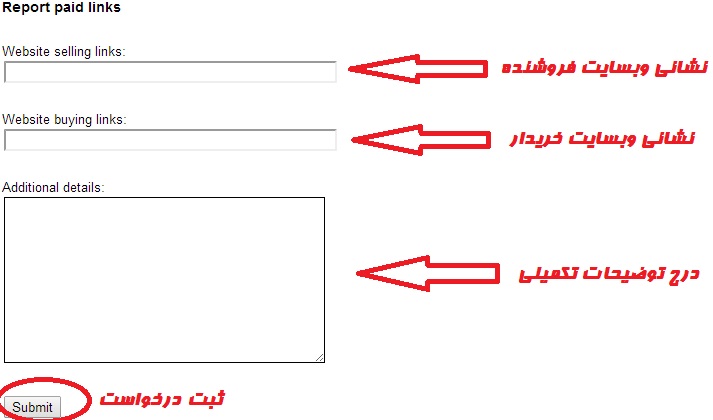

مراحل ثبت یک گزارش خرید و فروش بک لینک غیر طبیعی به صورت تصویری:

![]()

فایل robots.txt چیست و چگونه عمل می کند؟

ربات های وب (که به نام های سرگردانان وب، خزندگان یا عنکبوت ها نیز شناخته می شوند) به برنامه هایی می گویند که به صورت خودکار سراسر وب را می گردند و جستجو می کنند. موتورهای جستجویی نظیر گوگل از آنها برای محتوای درون وب استفاده می کنند و اسپمرها برای به دست آوردن ایمیل آدرس ها. آنها کارایی های بی شماری دارد.

توضیحات واضح در مورد فایل robots.txt

دارندگان سایت ها از robots.txt جهت معرفی ساختار سایتشان به ربات های سراسر وب استفاده می کنند.

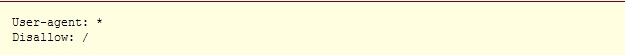

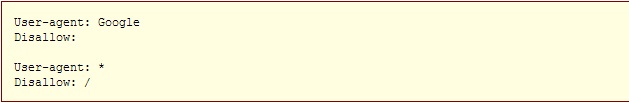

یک مثال در ارتباط با چگونگی کارکرد این فایل: یک ربات جستجوگر مثل ربات گوگل قصد ورود به سایت شما را دارد تا موارد مورد نظرش چون خطاها، صفحات، محتوا، تصاویر و غیره را ایندکس کند. در صورتی که صفحه ورودی شما http://www.example.com/welcome.html باشد، ربات مورد نظر ابتدا و پیش از هر نوع بررسی سایت شما نشانی http://www.example.com/robots.txt را چک خواهد کرد. و در نهایت به این دستورات بر خواهد خورد:

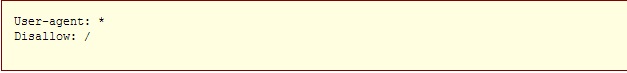

عبارت User-agent: * به معنای این است که این سایت و این دستور برای هم? ربات ها یکسان است. و قسمت Disallow: / حاوی این پیام است که هیچ رباتی نباید هیچ قسمتی از این سایت را بررسی و مشاهده نماید.

دو نوع نگرش نسبت به استفاده کنندگان از robots.txt وجود دارد:

1. ربات ها می توانند robots.txt شما را نادیده بگیرند! به خصوص آنکه ربات های مخرب، کارشان اسکن نمودن سراسر وب برای یافتن نقص های امنیتی، ایمیل آدرس ها و غیره است، کوچکترین توجهی به محتویات robots.txt ندارند.

2. فایل robots.txt یک فایل در دسترس عموم می باشد. هرکسی می تواند ببیند که شما کدام قسمت را تمایل ندارید که ربات های دیگر ببینند.

*پس برای مخفی نمودن اطلاعاتتان با استفاده از robots.txt تلاش نکنید.

نحو? ساخت یک فایل robots.txt

کجا آن را قرار دهیم؟

پاسخ کوتاه: در بالاترین سطح دایرکتوری سرور سایتتان

پاسخ کامل: زمانیکه یک روبات به دنبال فایل robots.txt برای نشانی URL شما می گردد، به دنبال اولین اسلش پس از اکستنشن شما می رود و به صورت اتوماتیک عبارت robots.txt را قرار می دهد.

برای مثال اگر داشته باشیم: http://www.example.com/shop/index.html، ربات مورد نظر /shop/index.html را حذف نموده و /robots.txt را جایگزین و در انتهای URL قرار می دهد.

به همین خاطر شما به عنوان دارنده سایت می بایست این فایل را در مکان صحیح و جایی قرار دهید که در نتایج جستجو دیده شده و عمل نماید. معمولا این فایل را در جایی مشابه همان صفحه اصلی سایت (index.html) یا همان صفح? به اصطلاح خوشامدگویی قرار می دهند.

*فراموش نکنید که تمام حروف این فایل کوچک نوشته می شوند: صحیح: robots.txt ؛ غلط: Robots.TXT

چه چیزی در آن بنویسیم؟

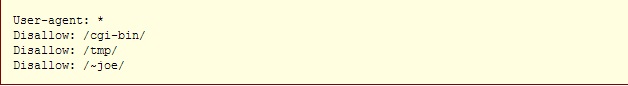

فایل robots.txt یک فایل متنی است که از یک یا تعداد بیشتری از دستورات ساخته شده است. به صورت معمول شامل یک دستور شبیه به این می شود:

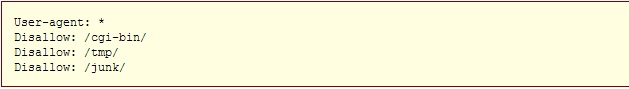

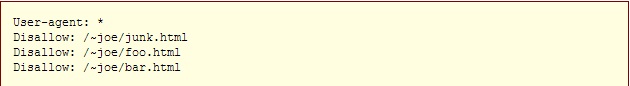

در مثال فوق شاهد 3 دایرکتوری محروم شده هستید که با استفاده از این 3 دستور، پیامی به ربات های سراسر وب ارسال می کند که به معنی عدم دسترسی ایشان به فایل های مشخص شده است.

توجه داشته باشید که برای محروم نمودن ربات ها به یک URL خاص، باید در هر خط مجزا یک دستور جدید را وارد نمایید. شما نمی توانید دستور Disallow: /cgi-bin/ /tmp/ را در یک خط وارد نمایید. همچنین نباید در مقابل یک دستور، خط را خالی بگذارید چراکه برای ربات این تصور می شود که دستور مورد نظر برای تمام وبسایت شما قابل اجرا است.

ضمنا شما نمی توانید به صورت منظم و نامنظم دستورات داخل فایل را با یکدیگر ادغام نمایید. برای مثال علامت "*" در فیلد User-agent به معنای آن است که دستورات وارد شده در مقابل این عبارت برای تمامی ربات ها لازم الاجراست. به طور مشخص و عینی شما نمی توانید دستوراتی چون User-agent: *bot*", "Disallow: /tmp/*" or "Disallow: *.gif را در کنار همدیگر وارد نمایید.

بررسی دقیق نمایید که چه چیزهایی را نمی خواهید ربات ها ببینند. هرچیزی را که نمی خواهید آنها ببینند را به راحتی می توانید از دیدشان مخفی کنید. به مثال های زیر توجه بفرمایید:

خط فرمان به تمام ربات ها برای عدم دسترسی به کل سایت شما

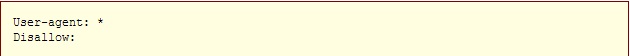

خط فرمان به تمام ربات ها برای دسترسی به کل سایت شما

برای اجرای دستور فوق همچنین می توانید یک فایل robots.txt بدون متن بسازید و هیچوقت به سراغش نروید.

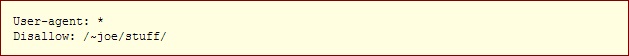

خط فرمان به تمام ربات ها برای عدم دسترسی به بخشی از سایت شما

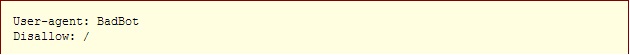

خط فرمان به یک ربات خاص برای عدم دسترسی اش به کل سایت (برای مثال نام ربات "BadBot" است)

خط فرمان به تنها یک ربات خاص جهت دسترسی به کل سایت شما و عدم دسترسی سایر ربات ها:

خط فرمان به تمام ربات ها برای عدم دسترسی به تمام فایل ها به جز برخی از آنها:

یا برای مشخص نمودن دقیق یک نشانی و یا فایل می توانید از این دستورات استفاده کنید و نشانی دقیق را در باکس robots.txt وارد نمایید.

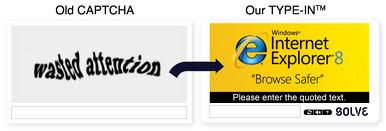

Captcha چیست؟

حتما تا بحال هنگام فعالیت های اینترنتی مانند تبادلات مالی آنلاین ،

ترافیک وب سایت ها و موتورهای جستجو ، نظرسنجی های آنلاین ، ثبت نام های

آنلاین ، سرویس های ایمیل رایگان و بسیاری دیگر از چنین موارد با کادری

روبرو شده اید که حاوی اعداد و یا حروف به صورت نامرتب و کج است Captcha

نرم افزاری ست که با پرسیدن سوالاتی که جواب دادن به آنها توسط انسان راحت

است می پردازد و به منظور حمله به این سیستم ها طراحی شده اند.Captcha در

واقع یک مکانیزم امنیتی محسوب می شود که تعیین می کند که طرف مقابل شما یک

کامپیوتر است یا یک انسان .لازم به ذکر است بدانیم که تست تورینگ توسط

انسان برگزار می شود و هدفش تشخیص ماشین است اما کپچا توسط ماشین برگزار می

شود و هدفش تضخیص انسان است.

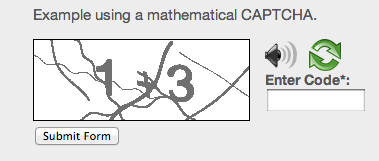

پنج نوع از کپچاهای مرسوم عبارتند از:

√ Captcha تصویری همراه با صدای تلفظ شده کاراکتر درون عکس

√ Captcha ای که باید عکس موردنظر را در تصویر پیدا کرد

√ Captcha ای که باید که مسدله ی ریاضی ساده حل کرد

√ Captcha های سه بعدی

√ Captcha هایی با استفاده از تبلیغات

با استفاده از کپچا تنها انسان ها قادر به انتشار نظر در بخش وبلاگ سایت

شما خواهند بود و به این ترتیب نیاز به عضویت در سایت یا وبلاگ شما برای

جلوگیری از نظرات اسپم نیست.

سایت هایی مثل گوگل و یاهو که نیازمند

عضویت تعداد بسیاری از افراد هستند قبل از بکارگیری کپچا مشکلات زیادی نظیر

ساخت تعداد زیادی از اکانت دارند که بتوانند در چند دقیقه صدها ایمیل

بسازند اما پس از استفاده از سیستم کپچا تنها انسان ها قادر به تکمیل فرم و

ثبت نام نهایی می باشند و امروزه به یک ضرورت در سیستم های رایگان تبدیل

شده است.

از کاربردهای دیگر کپچا می توان به جلوگیری از هک شدن اشاره

کرد به طوریکه با چند تلاش اشتباه در سیستم های ایمیل مانند یاهو یک کپچا

به کاربر نشان داده میشود تا از این روش هک جلوگیری شود.

نکته ی مهم :

استفاده از کپچاهایی که تشخیص آن حتی برای انسان هم مشکل است موجب ترک

کاربران می شود همچنین بکارگیری روش های دیگری مانند شناسایی نظرات اسپم و

ذخیره در حافظه سرور میتوانند جایگزین مناسبی برای کپچا در سایت های کم

بازدید باشند.

کدام را انتخاب کنیم: سئو یا طراحی و بهینه سازی؟

تصور می کنیم که شما 2 سایت طراحی کرده اید و هرکدام در دو زمینۀ متفاوت و مختص به خود مشغول به فعالیت هستند. یکی از این سایتها را 2 سال پیش طراحی نموده اید و در جریان این 2 سال فعال بوده است. و دیگری را حدود 1 ماه است که اجرا نموده و هر روز مطالبی تخصصی در آن درج می کنید.

هیچ کدام از این 2 سایت سئو نشده اند. حال قصد دارید سایت شمارۀ 3 را در یکی از همان دو زمینۀ تخصصی راه اندازی کنید.

اکنون این پرسش مطرح می شود: آیا باید سایت قدیمی را بهینه سازی و سئو کنید و یا از نو سایتی دیگر طراحی کنید و از همان ابتدا آن را سئو، بهینه سازی و اصولی نمایید؟

این پرسش مدت هاست در ذهن مدیران وبسایت هاست. ما در مثال بالا بهترین حالت ممکن را آوردیم. حالتی که سایت پیشین هم فعال بوده و تنها سئوی خاصی بر روی آن انجام نگرفته است. اکنون فرض کنید که سایت قدیمی با قدمت 2 ساله نه تنها سئوی مناسبی نداشته که محتوای تکراری و کپی درج نموده، دورۀ زمانی مشخصی برای به روزرسانی انجام نداده، و همچنین از ابزار وبمستر تولز نیز کوچکترین بهره ای نبرده تا آنالیزی هرچند کلی از تارنمای مربوطه داشته باشد.

در ارتباط با مدل شمارۀ 1، پاسخ مورد نظر متفاوت با مدل شمارۀ 2 می باشد. از همین مثال دوم آغاز می کنیم:

پاسخ کوتاه این است که سئوی تارنمای مذکور با توجه به عدم استفادۀ وبمستر آن از ابزار وبمستر تولز گوگل، اگر ناممکن نباشد به شدت غیر قابل پذیرش است که بتواند توجه ربات ها و صفحات نتایج جستجوی گوگل را به خود معطوف کند (آن هم با این ارفاق که از کنار لینک های جریمه شده بگذریم!).

اما نشدنی هم نیست. این نشدنی نبودن به راحتی طراحی یک سایت جدید نیست و بسیار سخت خواهد بود. از موارد ساده ای که می توان به آن اشاره کرد، ثبت سایت در موتورهای جستجو، ثبت در وبمستر تولز گوگل و آنالیز کامل آن پس از حدود 1 ماه، تولید محتوای جدید، رفع خطاهای واکنش دستی و غیره! برای مشاوره و راهنمایی با کارشناسان ما تماس بگیرید!

و اما مورد یکم که مرتبط با سایتی است که 2 سال فعالیت مداوم داشته، تولید محتوا نموده اما بر اساس اصول سئو حرکت نکرده است هرچند که اولین اصل سئو تولید محتوای جدید و غیر تکراری است.

چنین سایتی با صرف زمان قابل توجهی به آسانی و البته با استفاده از متخصصین مجرب، امکان ارتقای پلکانی و حتا آنی را داشته و در جایگاه حقیقی خود در صفحات نتایج جستجوی گوگل قرار خواهد گرفت. خواه رتبۀ یکم و خواه رتبه دهم!

از روش های موثر و آغازین سئوی یک سایت، ثبت آن در وبمستر گوگل، ارسال ربات های گوگل یا Crawlerها جهت بررسی تک تک لینک های تارنمای مورد نظر، کشف و اصلاح خطاهای سرور اعم از 404، 503 و امثالهم، یافتن Manual Actionها، ساختن بک لینک داخلی و ارسال و دریافت بک لینک حقیقی خارجی و مواردی از این دست می باشند.

توجه داشته باشید که سئو تنها محدود و منحصر به ایجاد چند لینک داخلی، یافتن و حذف و اصلاح نمودن لینک های تخریب شده و غیر قابل استفاده نیست. سئو شدن یک وبسایت نیازمند فردی متخصص در همین زمینه می باشد که به جای اصلاح، سایت را به اعماق جریمه ها و نابودی کامل آن نکشاند. بارها در سایر مقالات و کتب سئوی زیاد و عدم سپردن بهینه سازی سایت به دست افراد نابلد، طرح شده است. همانطور که برای هر آچاری که بر ماشین تان می کشید ارزش قائلید و نگران هستید، همان را به سطح سایت خود ارتقا داده و جلوی تخریب آن را نه تنها گرفته که به بهترین وجه ممکن کار رو تمام خواهیم نمود.

توجه بفرمایید که در بسیاری از سرویس های وب نویسی، عدم ایجاد تغییرات در برخی از این سرویس ها به صورت هشدارگونه در ارتباط با فایلهایی چون robots.txt مطرح گشته است. در ارتباط با robots.txt بیشتر بخوانید.