سئو-طراحی سایت

سئو-طراحی سایتسئو-طراحی سایت

سئو-طراحی سایتراهکارهایی برای بهینه سازی و سئوی سایت برای موبایل

با گسترش تلفن های همراه هوشمند در بازار، این بازار سهم بیشتری را اکنون به خود اختصاص داده است. حالا این بسیار مهم است که وبسایتها یک نسخۀ موبایل هم برای صفحاتشان داشته باشند؛ یک نسخۀ خاص که صفحاتش کوچکتر و سریع لود شود. همچنین جایگزینی پاسخگو برای کاربران تلفن همراه در مقابل نسخههای سنتی و قدیمی باشد.

آیا در چشمان گوگل، تفاوتی میان طراحی واکنشگرا و نسخ قدیمی موبایل سایتها وجود دارد و در سئو موثر است؟ خوشبختانه بله! مهندس ارشد گوگل -مت کاتس- در یک ویدیویی که از وی منتشر شده، نگاهی به این موضوع داشته است.

در ابتدا، بسیاری از مردم میپرسند که اصولا طراحی واکنشگرا چیست. خب این یک موضوع کمابیش جدید است و حتا بسیاری از وبمستران اطلاعات دقیقی از این نوع طراحی ندارند.

به گفتۀ مت کاتس "طراحی واکنشگرا تنها بدین معنی است که همانطور که یک سایت با یک مرورگر دسکتاپی (کامپیوتری) کار میکنند، همانطور میتوانید به نسخۀ موبایل دسترسی داشته باشید. تنها، صفحات و همه آنچه که در وب میبینید تغییر سایز داده و سایز صفحه بر اساس صفحۀ مانیتور تلفن هوشمند شما تغییر خواهد کرد.

اما کدام؟ طراحی واکنش گرا یا موبایل سایت؟

قطعا این دو برای گوگل متفاوت است و جستجوگر آن نیز نسخه های واکنشگرا (قالب بندی با صفحۀ دسکتاپ، موبایل هوشمند و تبلت ها) را به نسخه های موبایل سایت، تبلت سایت و نسخه های دسکتاپی بیشتر ترجیح میدهد.

به معنای دیگر ، هرچه وبسایت و محتوای شما به صورت بهینه برای دستگاه های موبایل طراحی شده باشد، رتبه بالاتری برای کاربران آن دستگاه دارد. این موضوع به خوبی حس می شود که نمایش سایت های بهینه نشده و ضعیف در دستگاه های موبایل پارامتر مناسبی برای گوگل محسوب نمیشود.

برای ایجاد یک سایت واکنشگرا، نیاز است تا با داشتن دانش کدنویسی CSS تنها با چند خط کد، سایت خود را واکنشگرا نمایید. چراکه تفاوتی میان کدنویسی میان سایتهای دسکتاپی با سایتهای واکنشگرا نیست و با یک نوع کد نوشته میشوند.

تنها باید مسیر جستجو و خزیدن رباتهای گوگل را برای سایت واکنشگرای خود باز بگذارید. برای انجام این امر نیاز است تا محدود کننده های فایل Robots.txt را از میان برداشته و کدهای مورد نظر را در قالب سایت بگنجانید تا رباتها ضمن جستجوی بدون محدودیت در میان سایت شما، به راحتی سایت اصلی را از سایت واکنشگرا تشخیص دهند.

هنوز فکر می کنید وقت سئو و بهینه سازی وبسایت برای تلفن های هوشمند نرسیده است؟

حدود یکسال گذشت؛ تولبار پیج رنک به کجا رسید؟

تقریبا یک ماه دیگر می شود یک سال از زمانیکه شاهد آخرین آپدیت تولبار پیج رنک گوگل بودیم. + +

این ذات تکنولوژی است که حتا بهترین سرویس ها بیایند و در اوج به یک باره

ناپدید شوند. همانطور که بخش فیدخوان گوگل -گوگل ریدر- آمد و پس از مدت ها

دیگر نبود. و همانطور که از ابتدای سال 2014 پیش بینی هایی از همه سو بر

کاهش اعتبار و جمعیت فیسبوک می شود. پیش بینی هایی که حتا اگر تبلیغاتی

باشند و نوید افول فیسبوک در سالهای 2017 تا 2020 را بدهند، باز هم این

امکان وجود دارد و همیشه حتا بهترین ها هم پایدار نخواهند بود.

در مثالی دیگر و ملموس تر برای ایرانیان، اتاق های گفتگوی نرم

افزار پیام رسان یاهو را شاهد بودیم که دیگر نشانی از اتاق های یاهو نیست.

اما از این بحث ها که بگذریم، به موضوع پیج رنک و تلاش های اکثر وبمستران

جهت طراحی و به روز رسانی برای چند ربات گوگل و نه مخاطبین، باز میگردیم.

تکلیف کسانی که سالها برای گوگل سایت ایجاد کردند تا گوگل با سخت گیری

فراوان و بر اساس ضوابط و قوانینش که آن را الگوریتم می خوانند، نمره ای به

نام دامنه و صفحات سایت مورد نظر بدهند چه خواهد شد؟ اکنون که پیج رنک

نیست و الگوریتمی بس منضبط تر به نام مرغ مگس خوار آمده تا تمامی

وبسایتهایی که به وضوح کپی کاری می کنند را جریمه کند، چه بر آنانی خواهد

آمد که نه همۀ تلاش خود را برای گوگل کرده اند و نه تقلب و فریب در کارشان

بوده است؟

این موضوع خیلی پیچیده نیست. پیشتر در مقاله با عنوان "تاثیر محتوای تکراری بر سئو"، به صورت کلی تر به این موضوع نگاهی داشتیم.

پس از خداحافظی اعلام نشده و شاید موقت پیج رنک و آغاز فعالیت قدرتمند

الگوریتم مرغ مگس خوار، وبمستران به 2 دسته کلی تقسیم خواهند شد. 1- آنانی

که متقلب و فریب دهنده بودند؛ 2- آنانی که محتوای جدید، مفید و غیر تکراری

تولید کردند! انتشار الگوریتم مرغ مگس خوار، تاکیدی است بر اهمیت گوگل به

محتوای جدید و غیر تکراری (کپی نشده) و همچنین جریمۀ کپی کاران و متقلبین.

همچنین جریمه کنندۀ پاپ آپهای مزاحم و تبلیغاتی و مواردی از این دست که در

مقالات مختلف در ارتباط با آخرین آپدیت الگوریتم گوگل توضیح داده شده و در

آینده نیز در این باره مقالاتی برای علاقه مندان منتشر خواهد شد.

در این صورت افرادی که به موازات سئوی سفید، به نظر کاربران و مخاطبین دیگر

نیز احترام می گذارند و کار جدیدی را ارائه میدهند، مورد توجه خزندههای

تحت فرمان الگوریتم دسامبر 2013 قرار گرفته و سایرین منهای جریمههای

متفاوت که در مقالۀ واکنش دستی (Manual Actions) توضیح دادیم، شامل

جریمههای دیگری نظیر عدم نمایش وبسایتشان در نتایج جستجوهای گوگل خواهند

شد.

در پایان یادآور می شویم که حتا اگر پیج رنک گوگل، تصمیم

بگیرد پس از 1 سال خود را به روز نماید، باز هم تولیدکنندگان محتوا نه تنها

در اولویت هستند که در بیشتر اوقات، تنها سایت ها و وبلاگ هایی نمایش داده

خواهند شد که محتوایی را برای اولین بار منتشر می کنند؛ آنهم اکنون که مرغ

مگس خوار، بزرگترین ضد اسپمر در حیطۀ خود شناخته میشود. ادغام این

الگوریتم و پیج رنک، تولد و حمایتی بی سابقه از تولید کنندگان و مرگ و

پایانی برای سارقین زحمات دیگران اعم از ربات و انسان خواهد بود. همانطور

که زمان مرگ این جریان وقتی که شناسایی تگها هوشمند (و بی اعتبار از نظری

دیگر) شدند، فرا رسید.

عدم دسترسی گوگل به سایت

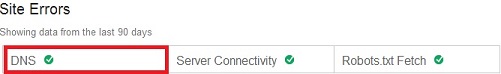

دلایل زیادی وجود دارد که دسترسی ربات گوگل به صفحات و یا کل یک سایت محدود و یا کاملا قطع شده باشد. یکی از این دلایل می تواند تنظیمات DNS دامین یا ایجاد مشکلاتی در سرور سایت باشد. این قبیل اتفاقات میتواند به Seoی سایت شما آسیب بزند و در موارد بسیاری، موتور جستجوگر و ربات گوگل نتواند صفحات سایت را ایندکس کند.برای یافتن اینکه آیا در تنظیمات DNSتان مشکلی وجود دارد یا خیر، گوگل در سلسلۀ ابزارهای وبمستر (Webmaster/tools...) به شما کمک خواهد کرد. برای پیدا کردن وجود یک مشکل در بخش DNS سایت خود به صفحه وبمسترتولز خود بروید و از مسیر Crawl، می توانید گزارشی از 90 روز قبل تا کنون را توسط این ابزار و این بخش مشاهده کنید.

جان مولر در این ارتباط میگوید:

این قبیل اتفاقات ممکن است در مدت کوتاهی بر سئو سایت شما تاثیر گذار باشد ولی در دراز مدت به جایگاه قبلی خود باز خواهید گشت. زمانیکه دسترسی روبات های گوگل به صفحات سایت شما ممکن شده و به بازخوانی مجدد و ایندکس آنها بپردازند دوباره جایگاه خود را در نتایج گوگل کسب خواهید کرد. ولی این امر نیازمند گذشت زمان خواهد بود. البته توجه داشته باشید که برگشت به جایگاه قبلی در صورتی رخ خواهد داد که تغییری اساسی در الگوریتم های گوگل در این زمان ایجاد نشده باشد.

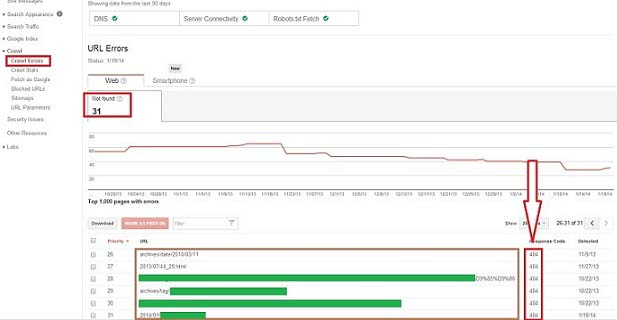

این سخنان بدان معناست که سرور هر سایتی ممکن است حتا با توجه به آپتایم 99 درصدی، در مواقعی (حتی دقایقی) با قطعی مواجه شود و یا با تنظیمات اشتباه و دسترسیها و محدودیتها با استفاده از فایل robots.txt، موجب بروز خسارتی چون عدم ایندکس شدن صفحات سایت توسط ربات گوگل گردد که با استفاده از یکی دیگر از امکانات وبمسترتولز یعنی بخش Crawl Errors نیز تا حد قابل توجهی حل شدنیست.

برای رفع این موضوع به بخش Crawl و زیرمنوی Crawl Errors بروید و لیست صفحاتی که به دلیل عدم وجودشان، خطا گرفته و ایندکس نشده اند را در دو نسخۀ وب و گوشی هوشمند، مشاهده نمایید. در 95 درصد از مواقع، این صفحات، صفحاتی هستند که دیگر وجود ندارند و همان خطای معروف 404 را با خود به یدک می کشند.

2 راه برای رفع این مساله وجود دارد: 1- نشانی های مورد نظر را محتوادار نموده و سپس Mark as fixed کنیم. 2- و یا از طریق حذف لینک ها به 3 روش (که توضیح آن از حوصلۀ این جستار خارج است) از وجود لینک های اضافی در سایت خود جلوگیری کنیم.

سپس می توانید از طریق گزینۀ Fetch as Google تا 500 دفعه، دستور دوباره ایندکس شدن صفحۀ اصلی و یا تمام صفحات سایت را وارد کنید تا مجددا گوگل، سایت شما را بازبینی و ایندکس نماید.